Make this article seo compatible, Let there be subheadings for the article, be in french, create at least 700 words

Google vient de monter la barre dans la guerre de l’IA, créant une concurrence féroce entre les grandes entreprises technologiques et les startups.

Le géant de la technologie, qui appartient à la société mère Alphabet, Inc., a annoncé qu’il préparait un nouveau grand modèle de langage, ou LLM, appelé Gemini 1.5. La première version de cette technologie, Gemini 1.5 pro, sera bientôt publiée pour des tests préliminaires, selon The Verge,

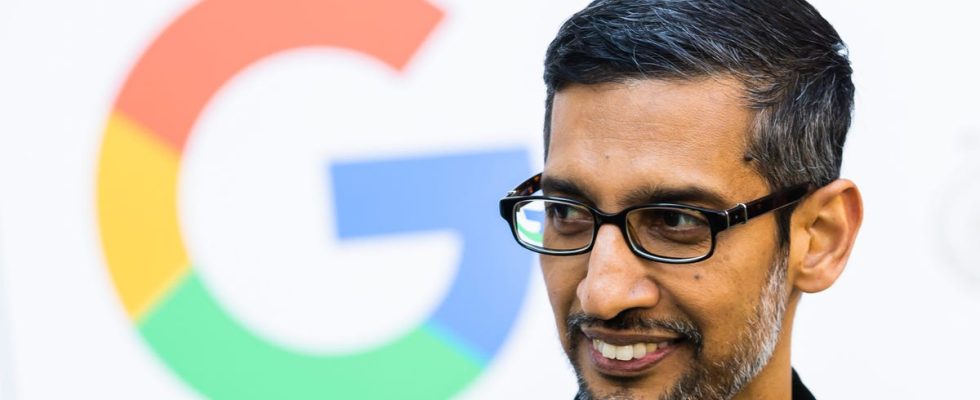

La nouvelle, qui a été décrite dans un article de blog d’entreprise rédigé la semaine dernière par Sundar Pichai, PDG de Google et d’Alphabet, et Demis Hassabis, PDG de Google DeepMind, survient deux mois seulement après que Google a dévoilé le Gemini original, censé être une réponse au GPT d’OpenAI. 4 et d’autres LLM créés par des startups et de grandes entreprises technologiques.

Gemini est un modèle d’IA multimodal de nouvelle génération, ce qui signifie que la technologie peut traiter plusieurs types de données, y compris une combinaison d’images, de texte, d’audio, de vidéo et de langages de codage. La technologie est destinée à être utilisée comme outil commercial et assistant personnel.

Gemini n’est pas la première incursion de Google dans l’IA : l’entreprise technologique a plutôt procédé début février à un « nettoyage » de ses différents outils d’IA et les a tous renommés Gemini.

Dans Gemini 1.5, les améliorations apportées à la nouvelle technologie dépassent de loin ce que le Gemini original peut faire. Voici ce que nous en savons jusqu’à présent.

Il utilise un modèle de « mélange d’experts »

Gemini 1.5 promet d’être plus rapide et plus efficace grâce à une technique de spécialisation appelée « mélange d’experts », également connue sous le nom de MoE. Au lieu d’exécuter l’intégralité du modèle à chaque fois qu’il reçoit une requête, le MoE de Gemini peut utiliser uniquement les parties pertinentes de sa puissance de traitement pour générer une bonne réponse.

Il y a une plus grande fenêtre contextuelle

La puissance d’un modèle d’IA est déterminée par sa fenêtre contextuelle, qui est composée des éléments de base utilisés pour traiter les informations. Ceux-ci peuvent inclure des mots, des images, des vidéos, de l’audio ou du code. Dans le monde de l’IA, ces éléments de base sont appelés jetons.

Le Gemini original pouvait gérer jusqu’à 32 000 jetons. Cependant, la capacité de la fenêtre contextuelle de Gemini 1.5 Pro peut gérer jusqu’à 1 million de jetons. Cela signifie que le nouveau LLM peut analyser plus de données que la version précédente : 1 heure de vidéo, 11 heures d’audio, des bases de code avec plus de 30 000 lignes de code ou plus de 700 000 mots, indique le blog de Google.

Par rapport aux versions précédentes, il a des performances améliorées

En testant le nouveau modèle d’IA par rapport à ses prédécesseurs, Gemini 1.5 Pro a surpassé son prédécesseur dans 87 % des tests de référence utilisés par Google, a indiqué la société.

De plus, 99 % du temps, Gemini 1.5 était capable de trouver un petit morceau de texte dans des blocs de données pouvant atteindre un million de jetons lors d’un test connu sous le nom d’évaluation « une aiguille dans une botte de foin ».

Gemini 1.5 s’améliore également dans la génération de bonnes réponses à partir de requêtes très longues, sans qu’un utilisateur ait besoin de consacrer beaucoup de temps supplémentaire à affiner ses requêtes. Google a déclaré que les testeurs avaient donné à Gemini 1.5 un manuel de grammaire pour une langue obscure, et que le LLM était capable de traduire du texte en anglais à un niveau similaire à celui de l’apprentissage humain.

Il a subi des tests de sécurité approfondis

À mesure que l’IA se renforce, les inquiétudes quant au rôle de la technologie dans les questions de sécurité, de la militarisation à la tromperie, augmentent également. Google affirme qu’en déployant Gemini 1.5, il a subi des tests approfondis d’éthique et de sécurité afin de donner le feu vert à une diffusion plus large. L’entreprise technologique a mené des recherches sur les risques de sécurité de l’IA et a développé des techniques pour atténuer les dommages potentiels.