Make this article seo compatible,Let there be subheadings for the article, be in french, create at least 700 words

L’intelligence artificielle fait rapidement partie de notre expérience mobile, avec Google et Samsung en tête. Cependant, Apple fait également des progrès significatifs en matière d’IA au sein de son écosystème. Récemment, le géant de la technologie de Cupertino a présenté un projet connu sous le nom de MM1, un grand modèle de langage multimodal (MLLM) capable de traiter à la fois du texte et des images. Aujourd’hui, une nouvelle étude a été publiée, dévoilant un nouveau MLLM conçu pour saisir les nuances des interfaces d’affichage mobiles. Le papier, publié par l’Université Cornell et souligné par Apple Insiderprésente « Ferret-UI : compréhension de l’interface utilisateur mobile basée sur les LLM multimodaux. »

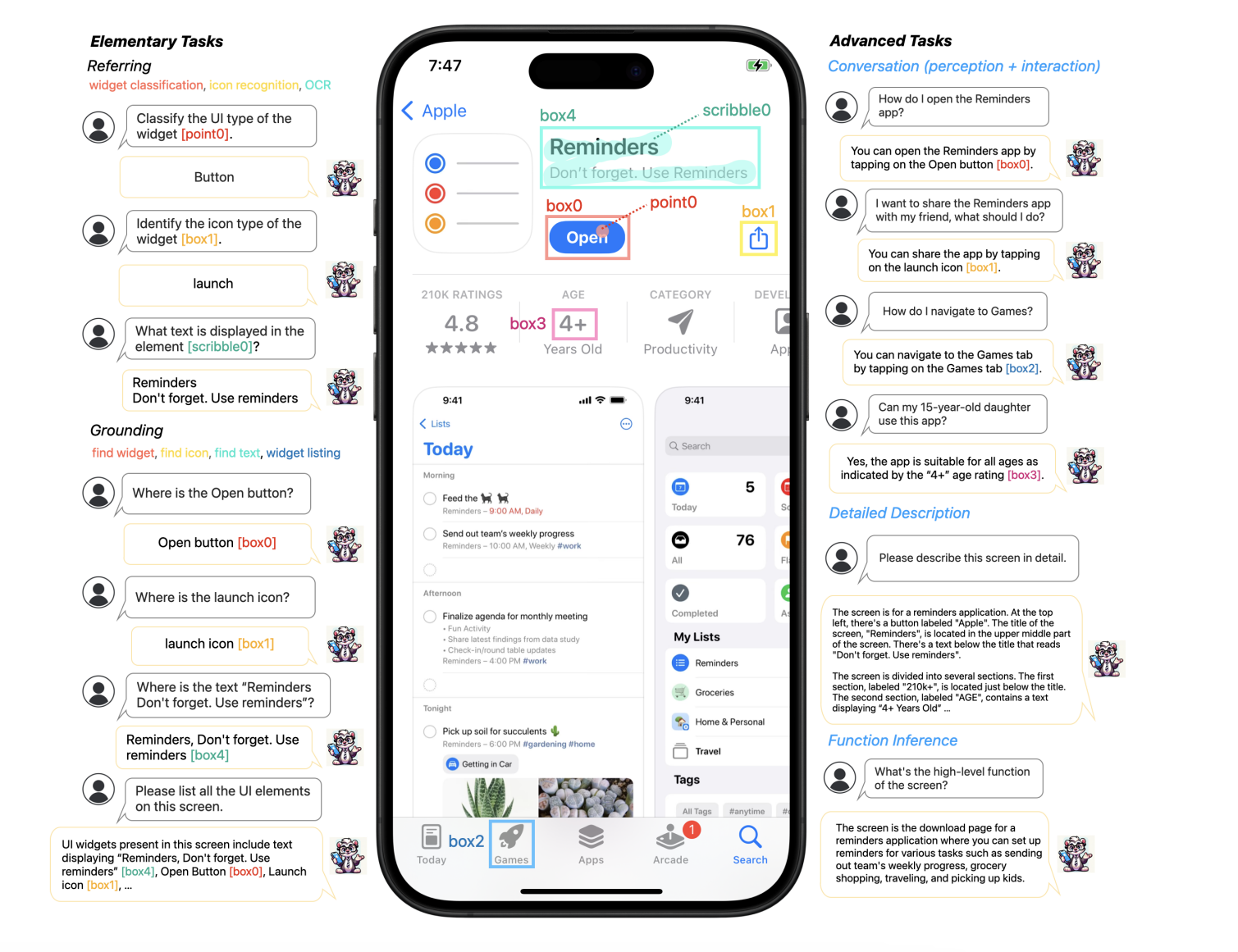

Ferret-UI est un nouveau MLLM conçu pour une meilleure compréhension des écrans d’interface utilisateur mobile, équipé de capacités de référence, de mise à la terre et de raisonnement.

Ferret-UI en action, analysant l’affichage d’un iPhone (Crédit image – Apple)

Pour résoudre ce problème, Ferret-UI introduit une fonction de grossissement qui améliore la lisibilité des éléments de l’écran en mettant à l’échelle les images à n’importe quelle résolution souhaitée. Cette capacité change la donne pour l’interaction de l’IA avec les interfaces mobiles.

Selon le document, Ferret-UI se distingue par la reconnaissance et la catégorisation des widgets, des icônes et du texte sur les écrans mobiles. Il prend en charge diverses méthodes de saisie telles que le pointage, le boxing ou le gribouillage. En effectuant ces tâches, le modèle acquiert une bonne compréhension des données visuelles et spatiales, ce qui l’aide à distinguer avec précision les différents éléments de l’interface utilisateur.

Ce qui distingue Ferret-UI, c’est sa capacité à travailler directement avec les données brutes des pixels de l’écran, éliminant ainsi le besoin d’outils de détection externes ou de fichiers d’affichage d’écran. Cette approche améliore considérablement les interactions sur un seul écran et ouvre des possibilités pour de nouvelles applications, telles que l’amélioration de l’accessibilité des appareils.

Le document de recherche vante la capacité de Ferret-UI à exécuter des tâches liées à l’identification, à la localisation et au raisonnement. Cette avancée suggère que les modèles d’IA avancés comme Ferret-UI pourraient révolutionner l’interaction avec l’interface utilisateur, en offrant des expériences utilisateur plus intuitives et efficaces.

Et si Ferret-UI était intégré à Siri ?

Bien qu’il ne soit pas confirmé si Ferret-UI sera intégré à Siri ou à d’autres services Apple, les avantages potentiels sont intrigants. Ferret-UI, en améliorant la compréhension des interfaces utilisateur mobiles grâce à une approche multimodale, pourrait améliorer considérablement les assistants vocaux comme Siri de plusieurs manières.

Cela pourrait signifier que Siri comprend mieux ce que les utilisateurs veulent faire dans les applications, peut-être même s’attaquer à des tâches plus complexes. De plus, cela pourrait aider Siri à mieux comprendre le contexte des requêtes en tenant compte de ce qui est à l’écran. En fin de compte, cela pourrait rendre l’utilisation de Siri plus fluide, lui permettant de gérer des actions telles que la navigation dans les applications ou la compréhension visuelle de ce qui se passe.