Make this article seo compatible,Let there be subheadings for the article, be in french, create at least 700 words

Opera a réalisé de nombreux investissements dans le département IA. Aujourd’hui, la société a dévoilé une autre fonctionnalité liée à l’IA qu’aucun autre navigateur ne propose actuellement : la possibilité d’accéder à des modèles d’IA locaux.

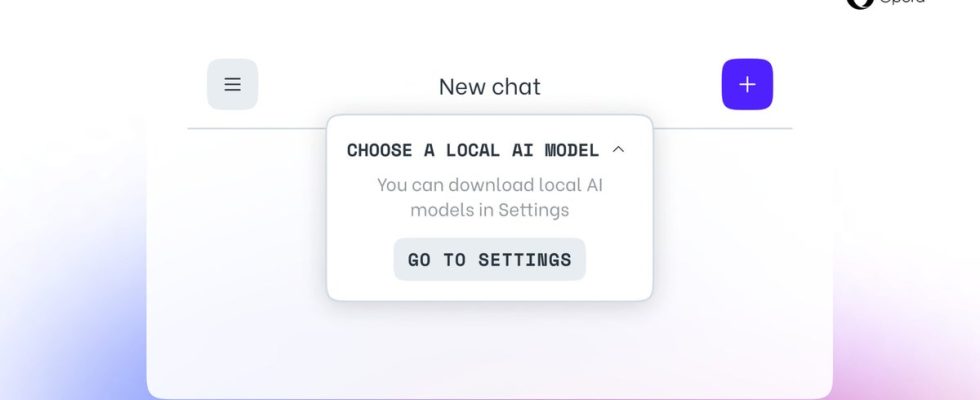

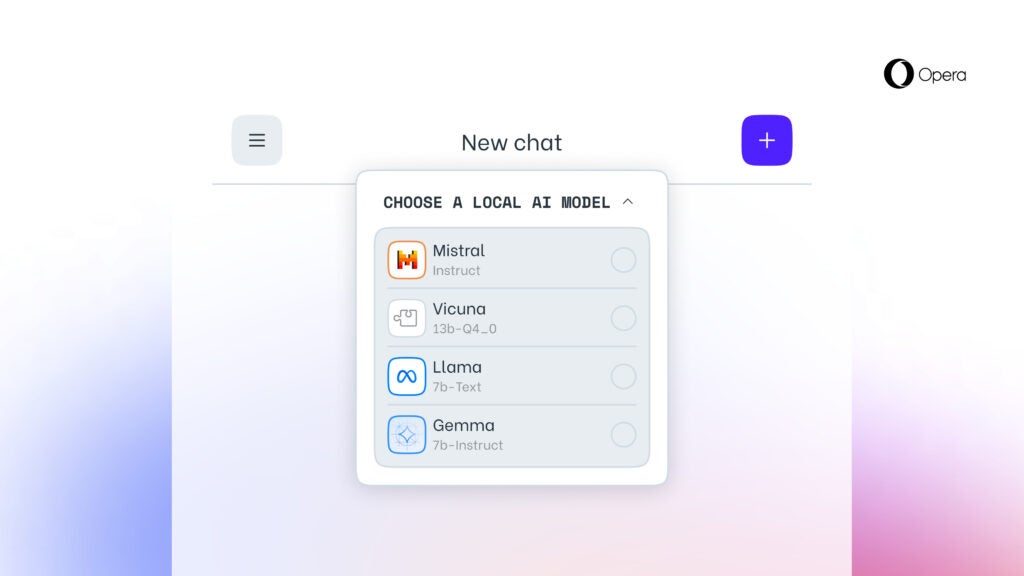

En ajoutant la prise en charge expérimentale de 150 variantes locales de LLM (Large Language Model) provenant d’environ 50 familles de modèles, le développeur permet aux utilisateurs d’accéder et de gérer les LLM locaux directement depuis son navigateur.

Selon Opera, les modèles d’IA locaux constituent un ajout gratuit au service en ligne Aria AI d’Opera, qui est également disponible dans le navigateur Opera sur iOS et Android. Les LLM locaux pris en charge incluent des noms tels que Llama (Meta), Vicuna, Gemma (Google), Mixtral (Mistral AI) et bien d’autres.

Gardez à l’esprit qu’après avoir sélectionné un certain LLM, il sera téléchargé sur votre appareil. Il est également important d’ajouter qu’un LLM local nécessite généralement 2 à 10 Go d’espace de stockage par variante. Une fois téléchargé sur votre appareil, le nouveau LLM sera utilisé à la place d’Aria, l’IA du navigateur natif d’Opera.