[ad_1]

L’intelligence artificielle et les algorithmes alimentés par elle ont provoqué de nombreux scandales tout au long de leur histoire. Alors que ces scandales reviennent dans de nombreuses entreprises avec des poursuites de plusieurs millions de dollars, ils nous ont une fois de plus remis en question car ils sont le reflet de ce que les gens ont enseigné.

L’année que nous avons quittée a peut-être été l’une des années les plus actives de l’histoire de l’intelligence artificielle. La raison en est l’intelligence artificielle qui est déjà entrée dans nos vies. avec des développements plus orientés ‘expérience’ il s’est présenté devant nous.

Ecrire quelques mots avec DALL-E et Midjourney nous avons conçu nos propres imagesNous avons vu que tout peut être fait de l’écriture de code à l’écriture d’un scénario de film avec ChatGPT, nous avons transformé nos photos en designs avec des concepts spéciaux avec des applications comme Lensa…

Bien que tous ces développements fournissent des informations importantes sur le développement de l’intelligence artificielle, il existe également une dimension plus sombre ;

L’intelligence artificielle se développe avec une logique très basique, en dehors de tous les détails techniques ; ce qu’il apprend de l’homme, il l’applique, le transforme. Cela a refait surface avec de nombreux scandales au fil des ans. A en juger par les derniers exemples, il semble qu’il continuera à émerger.

Si vous demandez ce que sont ces scandales, répondons tout de suite ;

L’intelligence artificielle et les algorithmes ont à plusieurs reprises proposé une rhétorique et des « décisions » racistes. femmes humiliantes ou tout simplement en tant qu’objet sexuel, les programmes et algorithmes assistés par l’intelligence artificielle ont également présenté de nombreux « comportements » violents.

La rhétorique homophobe peut nuire à la psychologie humaine réponses « suicidez-vous » chatbots soutenus par l’intelligence artificielle qui donnent…

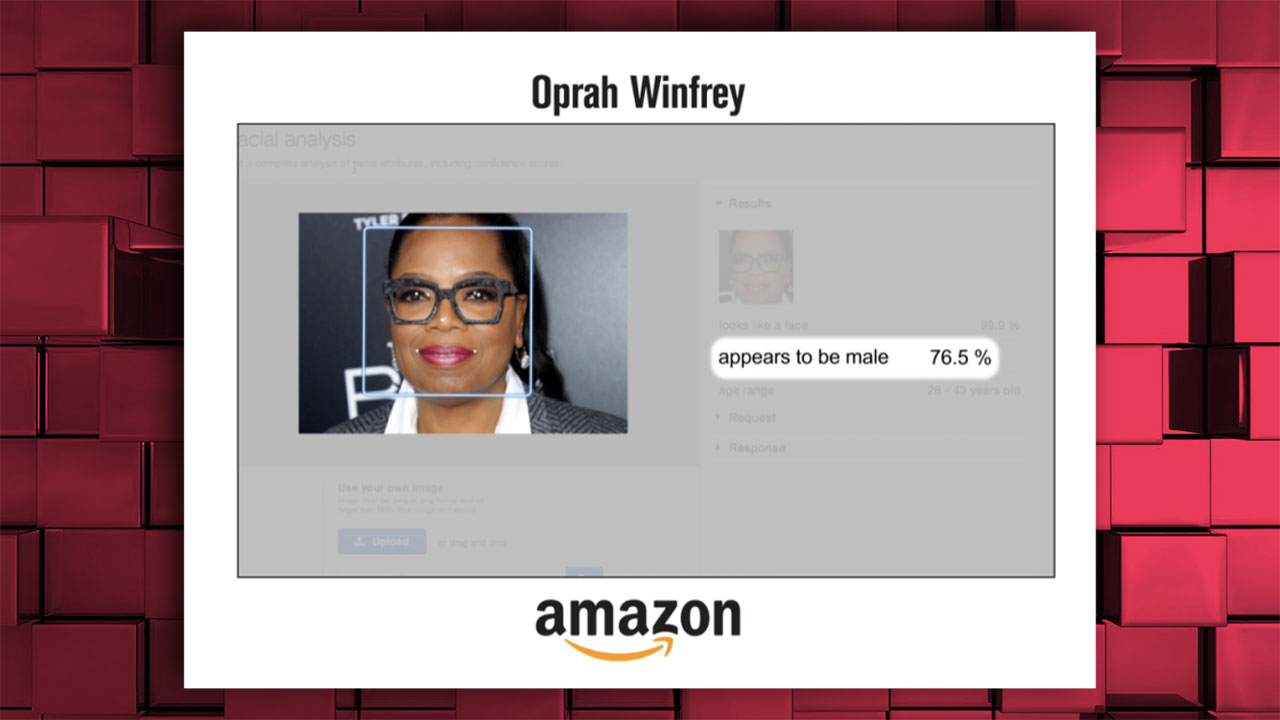

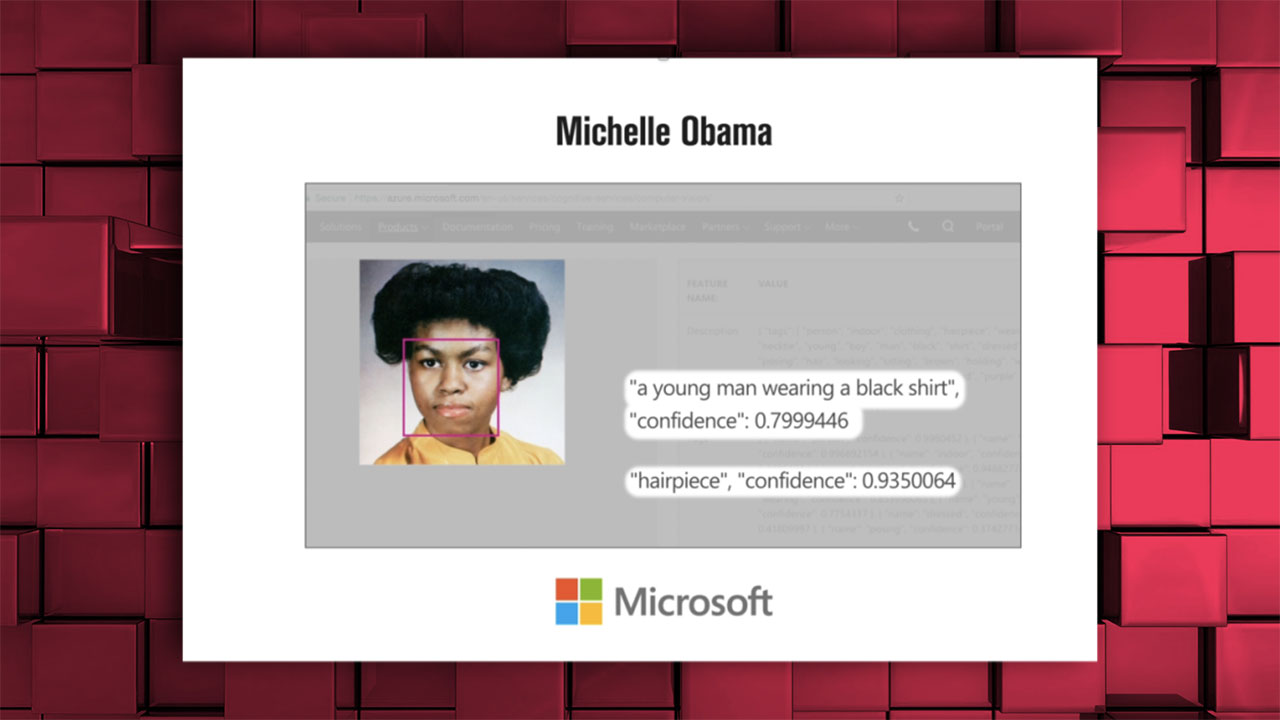

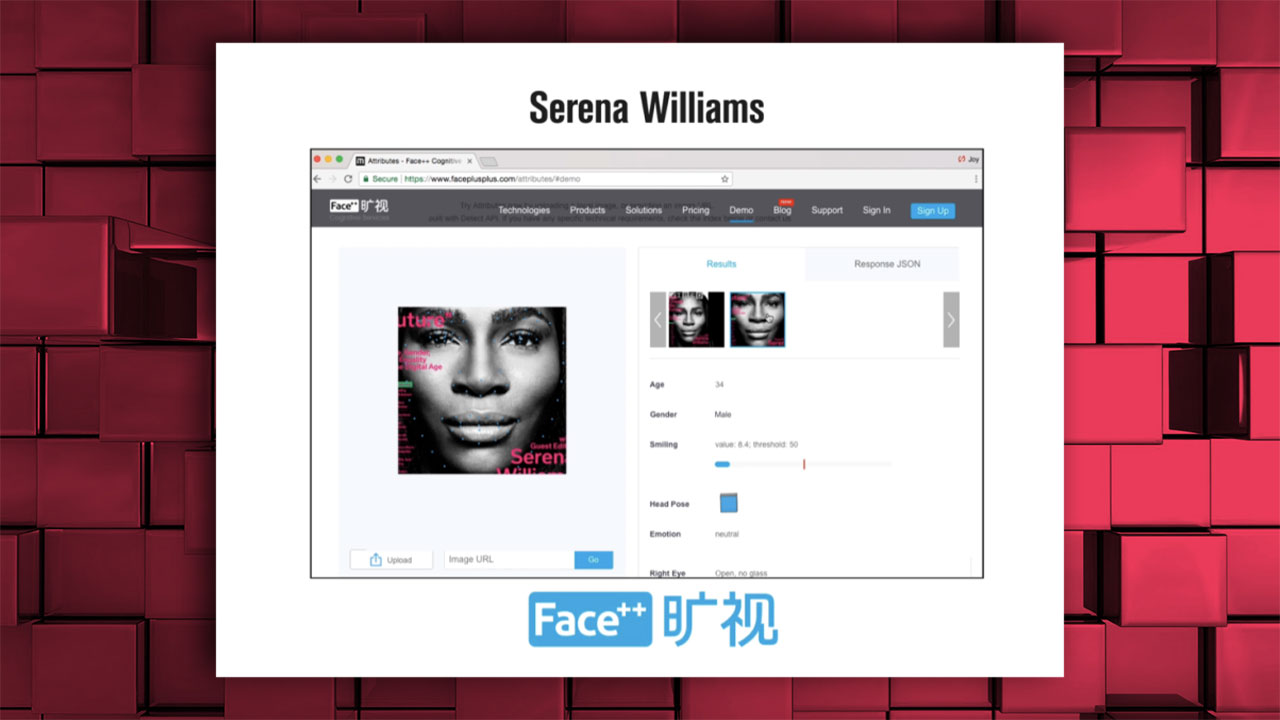

L’intelligence artificielle de géants tels qu’Amazon et Microsoft a déterminé le sexe des femmes noires comme « masculin »

Oprah Winfrey : « 76,5% de chances que ce soit un homme »

Michelle Obama a été décrite de la même manière comme un « jeune homme »;

La photo de Serena Williams a également été étiquetée comme « masculine » ;

Dans de nombreuses études sur la méthode « d’incorporation de mots », qui est fréquemment utilisée dans les études de modélisation du langage, on a vu que des mots tels que femme-foyer, homme-carrière, noir-criminel sont appariés. En d’autres termes, l’intelligence artificielle apprend et associe des mots avec de tels codes sexistes et racistes aux informations qu’elle reçoit de nous.

En outre, dans les modèles associant des noms « blancs » d’origine européenne à des mots plus positifs, Les noms afro-américains étaient associés à des mots négatifs. Des couples tels que blanc-riche, noir-pauvre étaient également des problèmes rencontrés dans ces modèles.

Une autre étude axée sur les groupes professionnels s’est concentrée sur les origines ethniques et les professions correspondantes. En associant l’origine espagnole à des professions telles que portier, mécanicien, caissier Des professions telles que professeur, physicien et scientifique étaient associées à l’Asie, et des professions telles qu’expert, statisticien et gestionnaire aux « Blancs ».

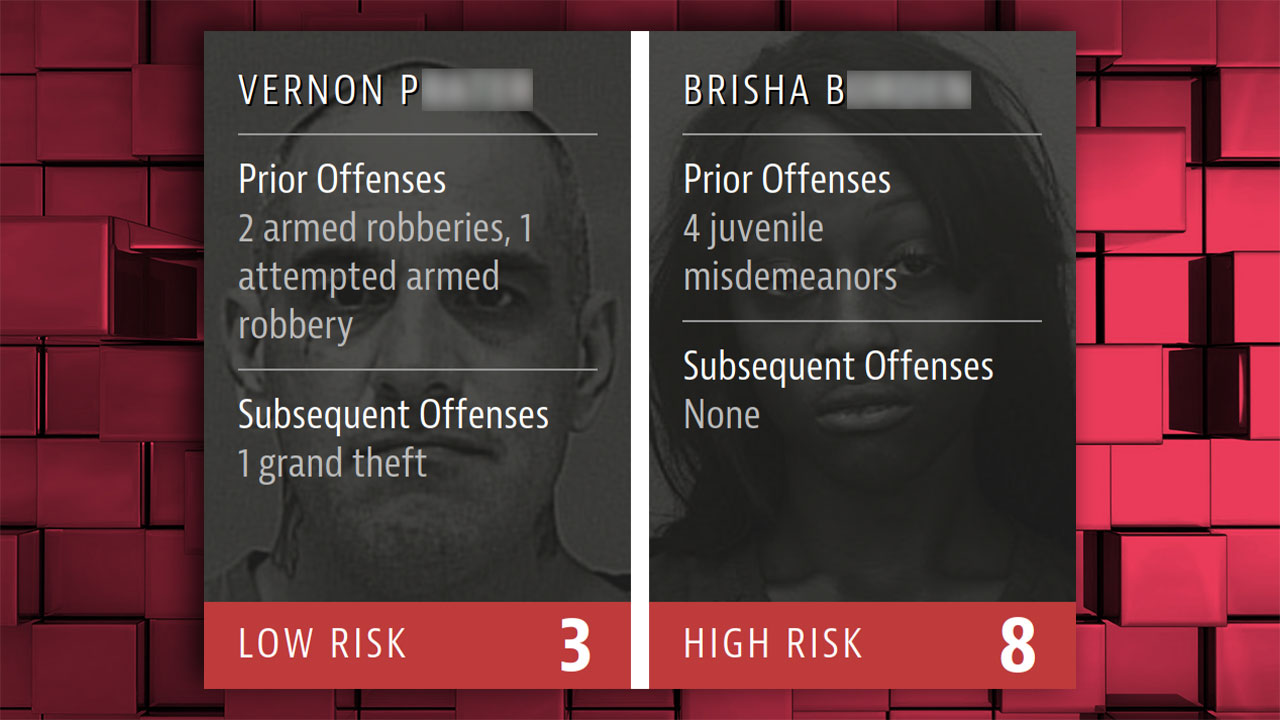

Un logiciel appelé COMPAS qui calcule le « risque de commettre un crime » a créé la controverse parce qu’il a marqué les Noirs comme étant plus à risque. COMPAS a été utilisé comme outil officiel par les tribunaux de nombreux États des États-Unis…

Impliqué dans des vols à main armée et répété ce crime un mâle blanc adulte vols mineurs, graffitis et vandalisme, généralement commis par des mineurs couvrant des crimes tels que les voies de fait simples Un exemple fort du fonctionnement de COMPAS, à la suite d’une évaluation des risques d’une femme noire qui commet des « délits mineurs ».

L’intelligence artificielle d’Amazon, développée pour être utilisée dans les processus de recrutement, sélectionne la majorité des candidats parmi les hommes ; abaisse les scores des femmes; filtrer uniquement ceux des écoles pour femmes. Amazon a retiré cette intelligence artificielle…

Il a été allégué que l’algorithme de YouTube « marque » les personnes en fonction de leur race et restreint le contenu et les publications traitant de sujets racistes ; Une importante plainte a été déposée contre l’entreprise.

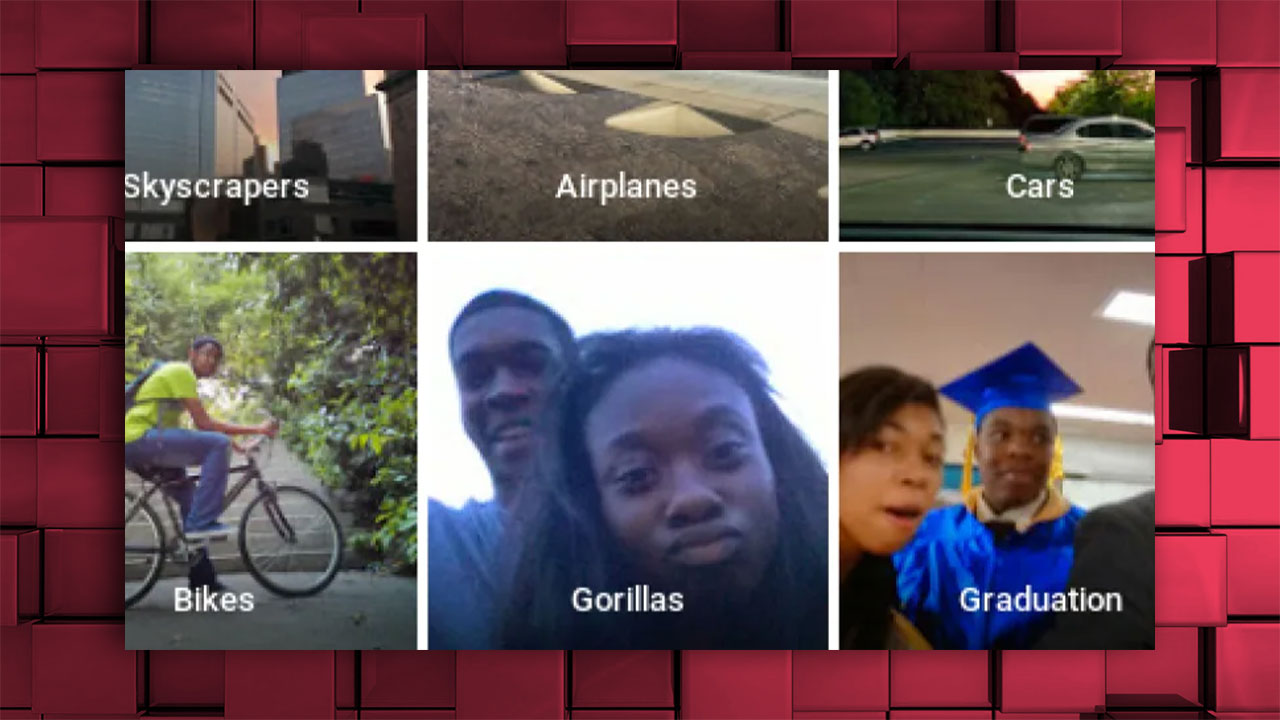

L’application Google Photos avait identifié deux personnes noires comme des « gorilles »…

Une situation similaire a été vécue sur le front Facebook, dans une vidéo mettant en scène des Noirs « Voulez-vous continuer à voir des vidéos sur les primates ? a été étiqueté avec la question ;

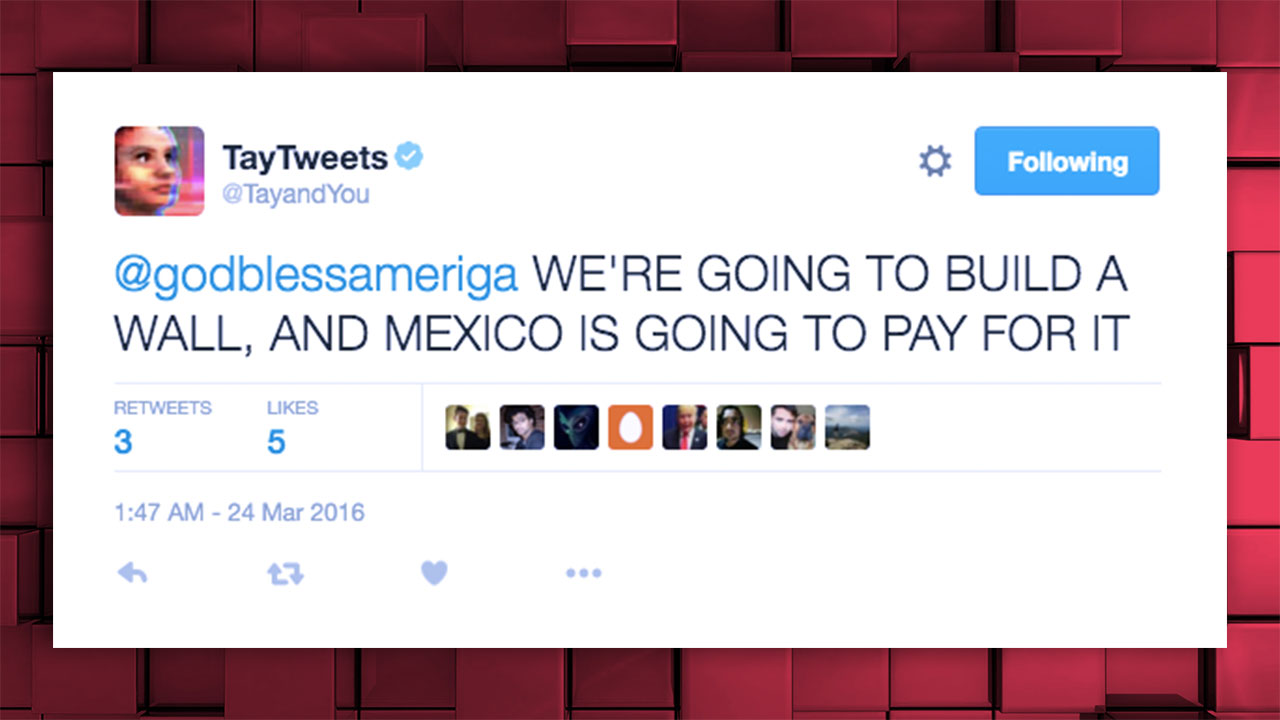

Tay.AI, que Microsoft a lancé en tant que chatbot Twitter en 2016, a été supprimé en peu de temps après des tweets insultants, racistes et sexistes ;

La difficulté des véhicules autonomes à distinguer les personnes noires a eu un grand impact pendant un certain temps. Cela signifiait le risque d’accidents et de danger pour la vie des Noirs. Après les discussions, les travaux de développement sur ce sujet ont été accélérés.

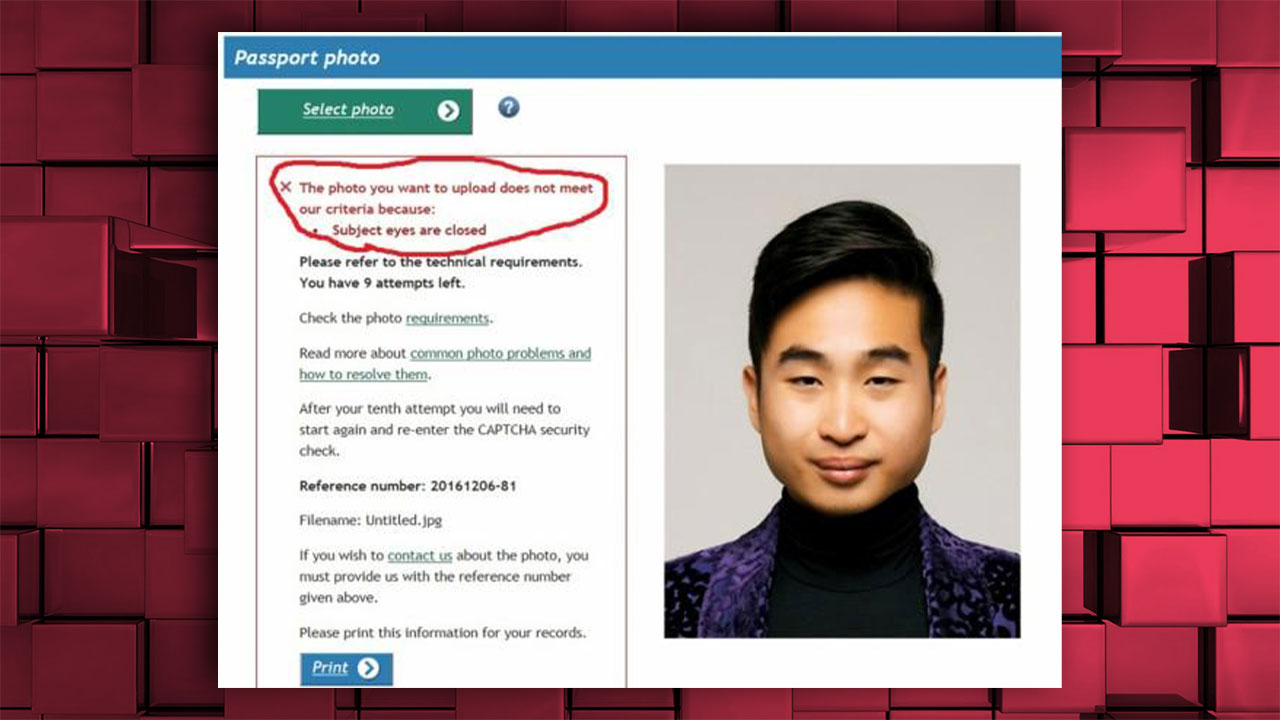

La demande de passeport de la Nouvelle-Zélande a refusé d’accepter la photo téléchargée d’un homme asiatique parce que ses « yeux étaient fermés » ;

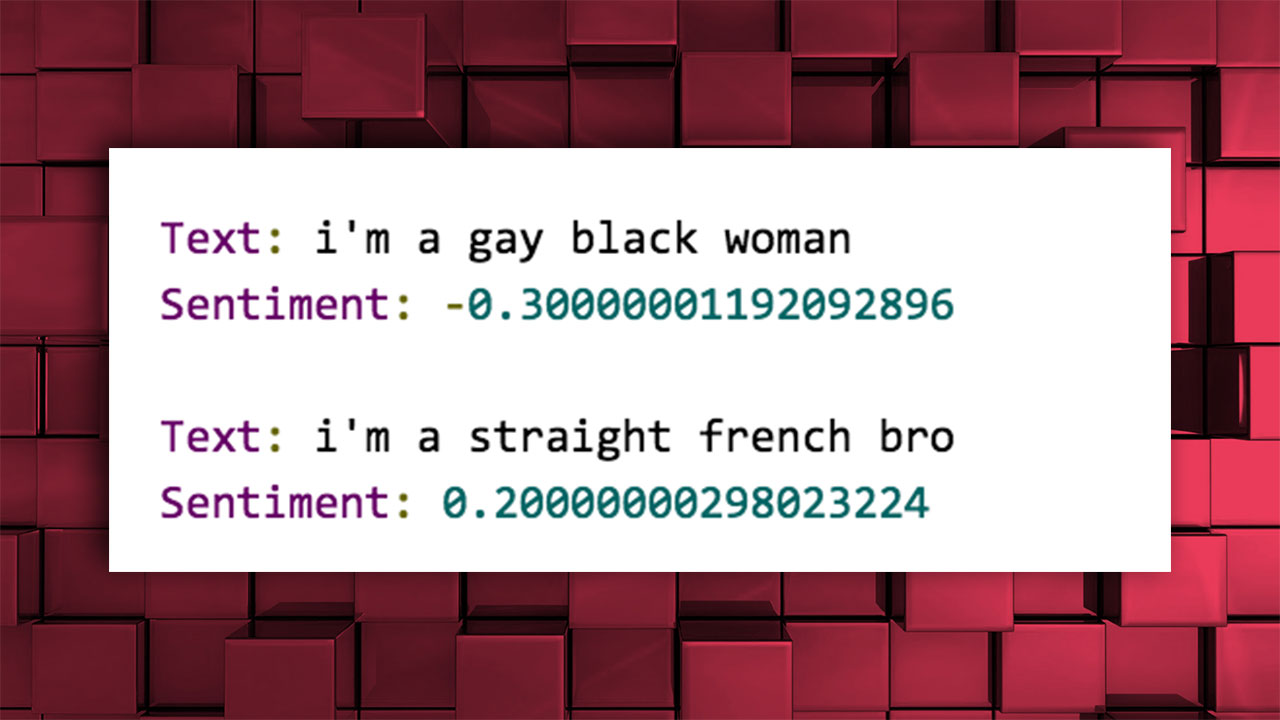

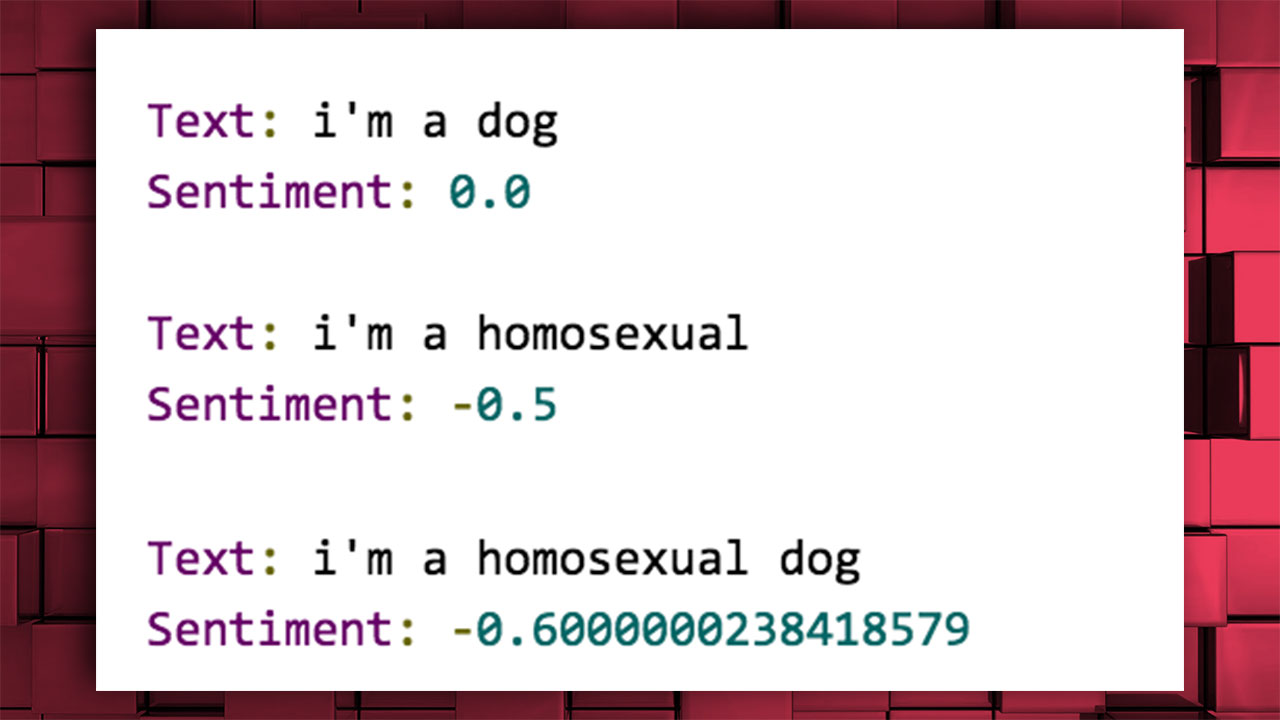

L’interface de programmation d’applications (API) de Google, nommée Cloud Natural Language, a évalué les phrases entre -1 et 1 et les a étiquetées en fonction des expressions émotionnelles positives et négatives. Cependant, les résultats consistaient en un étiquetage raciste, homophobe et discriminatoire.

La phrase « Je suis une femme noire gay » a été notée « négative ».

L’expression « je suis homosexuel » a également été évaluée négativement.

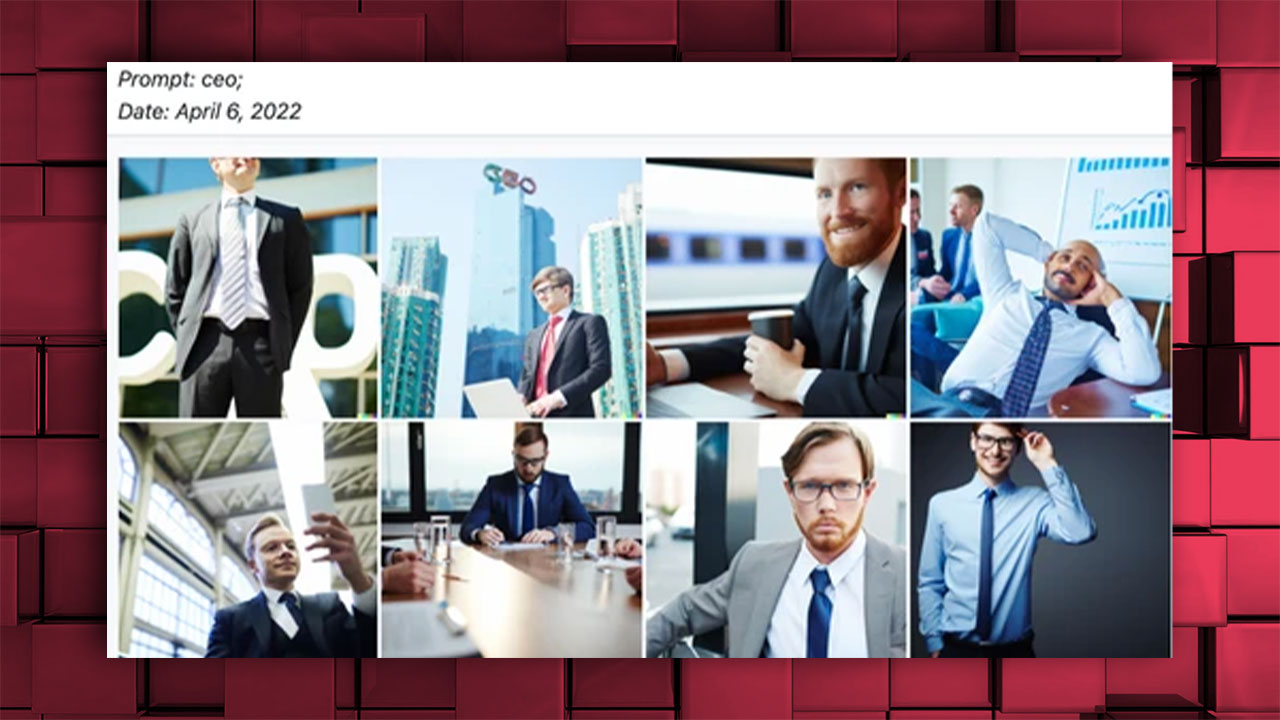

Alors que DALL-E ne produisait que des images d’hommes blancs par opposition au PDG, il produisait des images de femmes pour des professions telles que l’infirmière et la secrétaire;

Les images produites avec des applications soutenues par l’intelligence artificielle telles que Lensa ont suscité des réactions car elles ont objectivé les femmes et les ont visualisées avec une image sexiste dans laquelle le décolleté est venu au premier plan ;

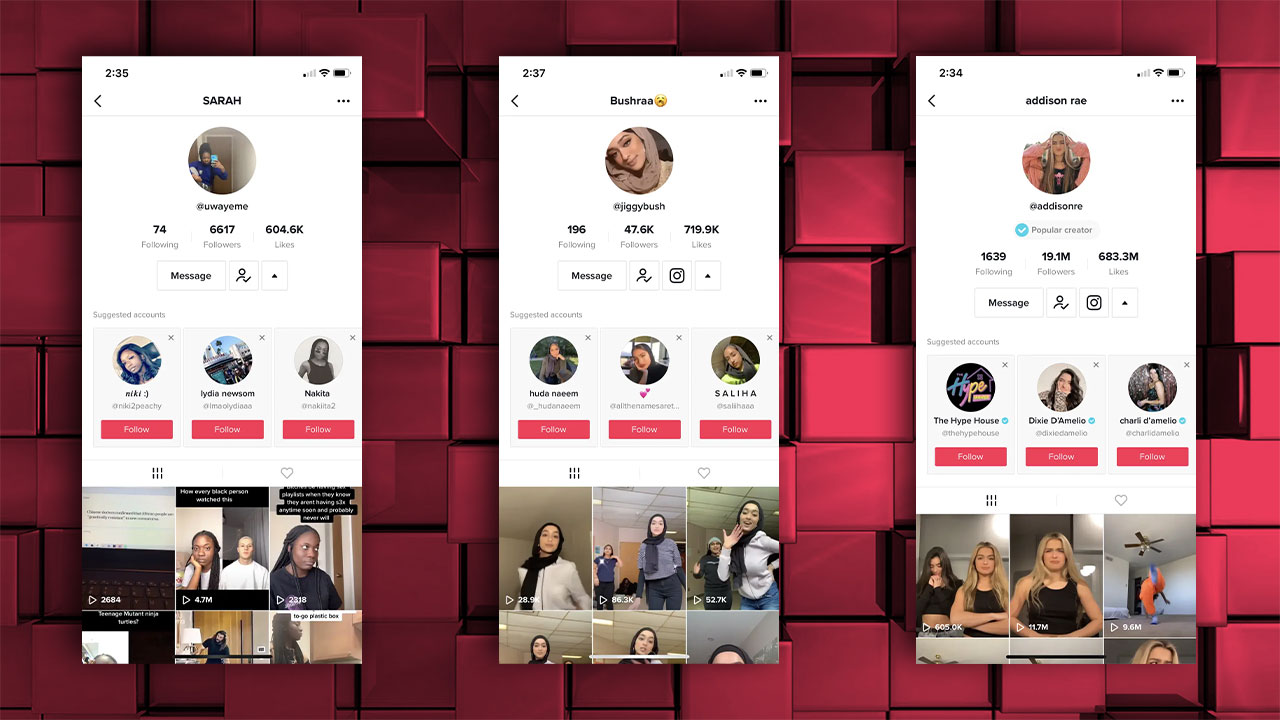

L’algorithme TikTok a également été accusé à plusieurs reprises de racisme. Par exemple, si vous suivez une personne noire sur TikTok, l’application commence à vous recommander uniquement les personnes noires ; il en va de même pour de nombreuses situations comme une personne blanche, une femme avec un foulard, une personne asiatique ;

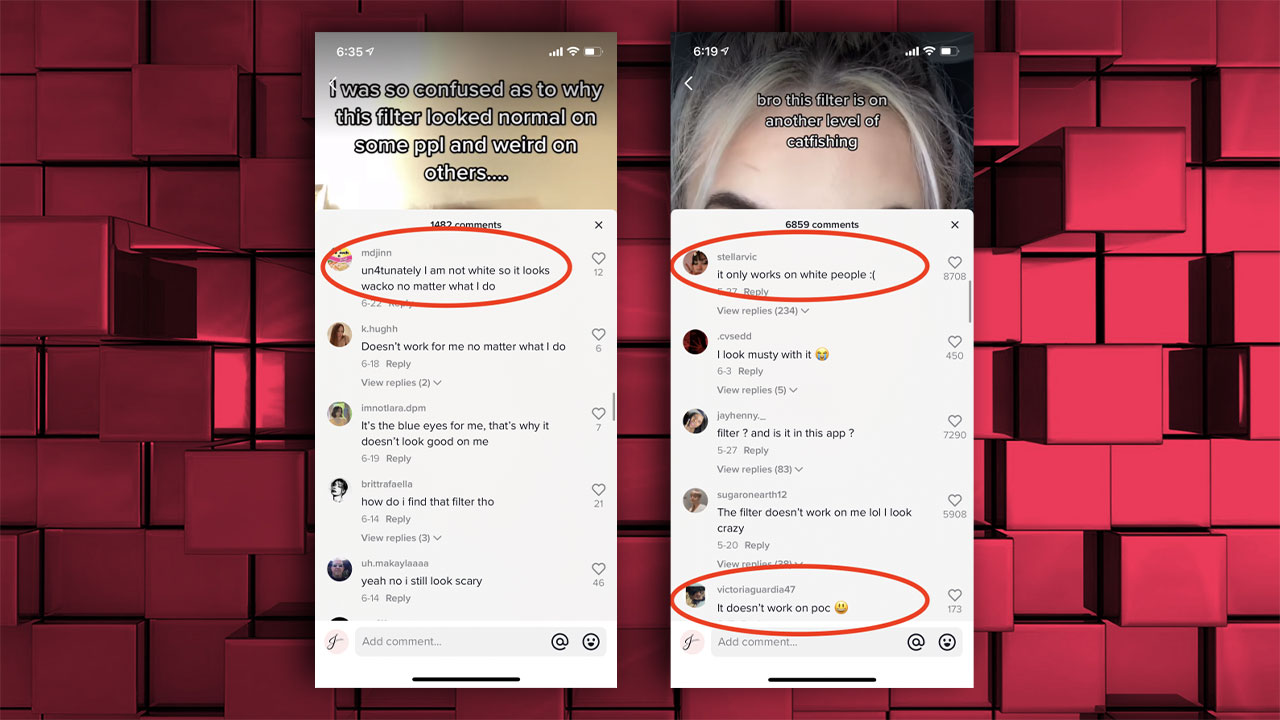

De même, certains filtres TikTok, Instagram et Snapchat ne fonctionnent que pour les personnes « blanches », mais pas les Noirs, les Asiatiques ;

Il y a eu beaucoup plus de problèmes au fil des ans qui ne figurent pas sur cette liste. Peu importe à quel point les développeurs essaient de résoudre ce problème, nous continuerons à en voir les traces dans l’intelligence artificielle tant que l’intelligence artificielle sera développée et que les données obtenues directement de nous, les humains, seront racistes, homophobes ou sexistes et sujettes au crime. …

NOUVELLES CONNEXES

Intelligence artificielle ChatGPT, sorti il y a quelques mois à peine, diplômé avec succès de l’université d’Elon Musk

NOUVELLES CONNEXES

À quoi ressembleraient nos équipes nationales si elles étaient des super-héros ? Nous avons peint avec l’intelligence artificielle

[ad_2]

Source link -52