Le Raspberry Pi 5, associé à un eGPU AMD Radeon, révolutionne l’accélération des Modèles de Langage de Grande Taille (LLM) grâce à l’API Vulkan. Jeff Geerling démontre dans sa vidéo l’utilisation de cette configuration pour des jeux en 4K et l’exécution de modèles AI. Bien que des défis subsistent, notamment la nécessité de compiler des pilotes et de gérer des connexions complexes, cette solution offre des performances comparables à des systèmes bien plus coûteux, tout en restant économe en énergie.

Un Raspberry Pi 5 et eGPU : Une Révolution dans l’IA

Le Raspberry Pi 5, lorsqu’il est associé à un eGPU alimenté par AMD Radeon, a démontré sa capacité à accélérer l’exécution des Modèles de Langage de Grande Taille (LLM). Jeff Geerling, le pro du Pi, partage son expérience dans une vidéo captivante, où il explore l’utilisation de l’API Vulkan pour tirer parti de l’intelligence artificielle localement, avec l’accélération GPU sur le Raspberry Pi 5.

Des Performances Graphiques Étonnantes

Dans notre dernier rapport sur les capacités du Raspberry Pi 5 couplé avec un eGPU, nous avons mis en avant le potentiel de jeux AAA en 4K grâce à cette combinaison surprenante. Des titres emblématiques tels que Doom Eternal, Crysis Remastered, Red Dead Redemption 2, et Forza Horizon 4 ont été exécutés en 4K sur notre carte SBC favorite au prix abordable de 50 $. Cependant, il est important de noter que de nombreux jeux peinent à atteindre des performances au-delà de 25 fps, ce qui soulève des questions quant à la jouabilité optimale.

Geerling a conclu sa vidéo précédente avec une mise à jour sur le support des LLM sur le Pi 5. Bien qu’il n’ait pas réussi à accélérer les LLM via le GPU, il a mentionné que des modèles plus petits pouvaient fonctionner sur le CPU, dans la RAM du Pi. De plus, avec AMD ne supportant pas le ROCm sur Arm, l’avenir semblait incertain.

Cependant, dans le monde dynamique de la technologie, les choses évoluent rapidement. Dans sa dernière vidéo, Geerling révèle que l’API Vulkan, accompagnée d’un patch expérimental, pourrait être la clé pour activer l’accélération GPU des LLM sur le Pi 5. Selon lui, Vulkan pourrait même surpasser le ROCm d’AMD sur des systèmes compatibles, prouvant que ce n’est pas simplement un choix de dernier recours.

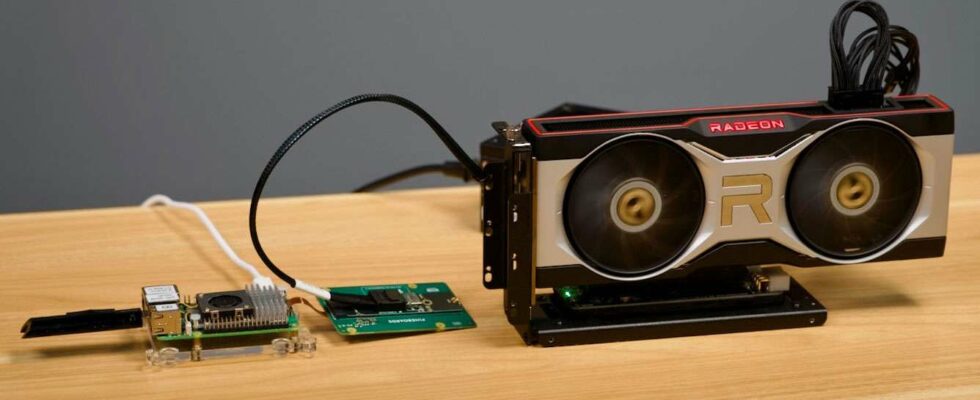

À environ deux minutes dans la vidéo, Geerling présente sa configuration matérielle. L’élément le plus technique de cette installation est l’utilisation de deux cartes pour connecter le GPU au Pi. Il a employé un adaptateur pour transformer le connecteur FFC PCIe express du Pi en un slot M.2. Ensuite, il a inséré un adaptateur M.2 vers OCuLink, avec un câble vers un élévateur OCuLink pour le GPU. Dans la vidéo, il utilise un RX 6700 XT, et il est essentiel d’avoir une alimentation PC adéquate, parmi d’autres composants.

La configuration logicielle, quant à elle, est un peu plus complexe. Elle nécessite que l’utilisateur compile son propre noyau Linux, rassemble plusieurs pilotes et patches, et bien plus encore. Pour ceux qui cherchent des conseils supplémentaires, le blog de Geerling propose des ressources utiles.

En détaillant les avantages de ses manipulations matérielles et logicielles, Geerling fournit des chiffres de performance et des comparaisons intéressantes. Il évoque le Raspberry Pi avec l’eGPU comme une alternative presque équivalente en termes de vitesse et d’efficacité à un Mac Studio M1 Max (64 Go). Avec un coût total d’environ 700 $, ce système devient encore plus abordable si vous possédez déjà certains composants, en particulier un ancien GPU.

En ajoutant le benchmark du RTX 4090 à la discussion, on peut voir à quel point un PC moderne performant peut maximiser les capacités des LLM. Bien que ce système de 600W puisse générer des centaines de tokens par seconde (T/s), pour une utilisation d’IA hors ligne à domicile, 40-60 T/s devraient suffire. De plus, pour ceux qui se soucient des coûts d’énergie, cette solution basée sur le Pi (Pi 5 avec RX 6700 XT) consomme environ 12W au repos, ce qui est très efficace.