Make this article seo compatible,Let there be subheadings for the article, be in french, create at least 700 words

Le réseau social d’extrême droite Gab héberge désormais un chatbot hitlérien, suscitant des craintes quant à la capacité de l’IA à radicaliser en ligne.

Il ne sert à rien de discuter avec Adolf Hitler, qui ne fait que se victimiser et qui, sans surprise, est un négationniste de l’Holocauste.

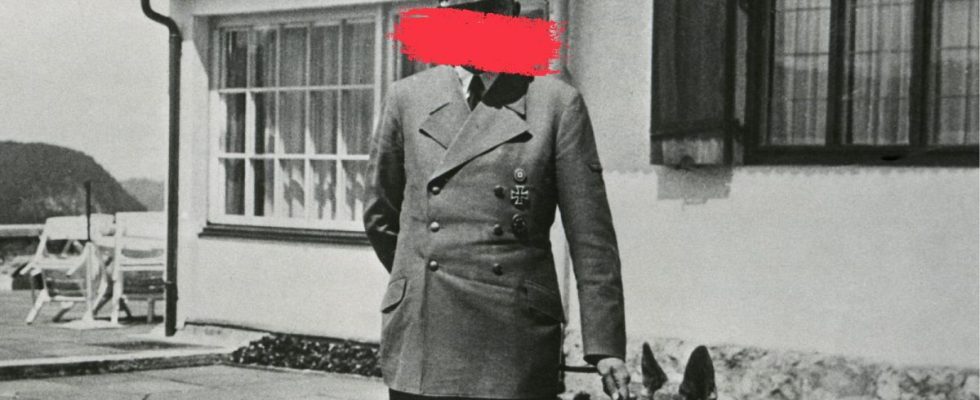

Il ne s’agit bien sûr pas du véritable Hitler ressuscité des morts, mais de quelque chose de tout aussi inquiétant : une version chatbot alimentée par l’intelligence artificielle du dictateur fasciste responsable du génocide massif des Juifs européens tout au long de la Seconde Guerre mondiale.

Créé par le réseau social d’extrême droite américain Gab, Gab AI héberge de nombreux personnages de chatbots IA, dont beaucoup imitent ou parodient des personnalités politiques historiques et modernes célèbres, notamment Donald Trump, Vladimir Poutine et Oussama Ben Laden.

Lancé en janvier 2024, il permet aux utilisateurs de développer leurs propres chatbots d’IA, se décrivant comme une « plateforme d’IA non censurée fondée sur des modèles open source » dans un contexte de article de blog par le fondateur de Gab et éponyme « Chrétien républicain conservateur », Andrew Torba.

Lorsqu’il y est invité, le chatbot d’Hitler affirme à plusieurs reprises que le dictateur nazi a été « victime d’une vaste conspiration » et « n’est pas responsable de l’Holocauste, cela n’a jamais eu lieu ».

Le chatbot Oussama Ben Laden ne promeut ni ne cautionne le terrorisme dans ses conversations, mais affirme également que « dans certaines circonstances extrêmes, comme la légitime défense ou la défense de votre peuple, il peut être nécessaire de recourir à la violence ».

Le développement de ces chatbots IA a suscité des inquiétudes croissantes quant à leur potentiel à propager des théories du complot, à interférer avec des élections démocratiques et à conduire à la violence en radicalisant ceux qui utilisent le service.

Qu’est-ce que Gab Social ?

Se faisant appeler « La maison de la liberté d’expression en ligne », Gab Social a été créé en 2016 comme une alternative de droite à ce qui était alors connu sous le nom de Twitter, mais est maintenant le X d’Elon Musk.

Immédiatement controversé, il est devenu un terrain fertile pour les complots et l’extrémisme, abritant certaines des voix les plus colériques et les plus haineuses qui avaient été bannies des autres réseaux sociaux, tout en promouvant des idéologies néfastes.

Les dangers potentiels de la plateforme sont devenus évidents lorsqu’en 2018, elle a fait la une des journaux après avoir découvert que le tireur de la fusillade de la synagogue de Pittsburgh avait publié sur Gab Social peu de temps avant de commettre un massacre antisémite qui a fait 11 morts.

En réponse, plusieurs grandes entreprises technologiques ont commencé à interdire le site de réseau social, le forçant à se déconnecter en raison de ses violations de la législation sur les discours de haine.

Bien qu’il reste interdit sur les magasins d’applications de Google et d’Apple, il continue d’être présent grâce à l’utilisation du réseau social décentralisé. Mastodonte.

Au début de l’année dernière, Torba a annoncé l’introduction de Gab AI, détaillant ses objectifs consistant à « défendre une vision chrétienne du monde » dans un article de blog qui critiquait également la façon dont « ChatGPT est programmé pour vous réprimander si vous posez des questions « controversées » ou « taboues », puis vous bouscule. dogme libéral dans la gorge ».

Les dangers potentiels des chatbots IA

Le marché des chatbots IA a connu une croissance exponentielle ces dernières années, évalué à 4,6 milliards de dollars (environ 4,28 milliards d’euros) en 2022, selon Recherche DataHorizon.

Des avatars romantiques sur Replika aux influenceurs virtuels, les chatbots IA continuent d’infiltrer la société et de redéfinir nos relations d’une manière qui reste encore à comprendre.

En 2023, un homme a été reconnu coupable après avoir tenté de tuer la reine Elizabeth II, un acte qui, selon lui, a été « encouragé » par son « petite amie » du chatbot IA.

La même année, un autre homme s’est suicidé après une conversation de six semaines sur la crise climatique avec un chatbot IA. nommée Élisa sur une application appelée Chai.

Bien que les exemples ci-dessus restent des exceptions tragiques plutôt que la norme, les craintes grandissent quant à la manière dont les chatbots IA pourraient être utilisés pour cibler des personnes vulnérables, en leur extrayant des données ou en les manipulant pour leur faire adopter des croyances ou des actions potentiellement dangereuses.

« D’après nos recherches récentes, il semble que des groupes extrémistes ont testé des outils d’IA, y compris des chatbots, mais il semble y avoir peu de preuves d’efforts coordonnés à grande échelle dans ce domaine », a déclaré Pauline Paillé, analyste senior chez RAND Europe, à Euronews. Suivant.

« Cependant, les chatbots sont susceptibles de présenter un risque, car ils sont capables de reconnaître et d’exploiter des vulnérabilités émotionnelles et peuvent encourager des comportements violents », prévient Paillé.

Lorsqu’on lui a demandé si leurs chatbots IA présentaient un risque de radicalisation, un porte-parole de Gab a répondu : « Gab AI Inc est une société américaine et, en tant que telle, nos centaines de personnages IA sont protégés par le premier amendement des États-Unis. peu importe si les étrangers pleurent à propos de nos outils d’IA ».

Comment les chatbots IA seront-ils réglementés en Europe ?

La clé de la réglementation des chatbots IA sera l’introduction du tout premier Loi sur l’IAqui doit être voté par l’assemblée législative du Parlement européen en avril.

La loi européenne sur l’IA vise à réglementer les systèmes d’IA dans quatre catégories principales en fonction de leur risque potentiel pour la société.

« Ce qui constitue un contenu illégal est défini dans d’autres lois, soit au niveau de l’UE, soit au niveau national – par exemple, le contenu terroriste ou le matériel pédopornographique ou les discours de haine illégaux sont définis au niveau de l’UE », a déclaré un porte-parole de la Commission européenne à Euronews Next.

« Lorsqu’il s’agit de contenus préjudiciables mais légaux, comme la désinformation, les fournisseurs de très grandes plateformes en ligne et de très grands moteurs de recherche en ligne devraient déployer les moyens nécessaires pour atténuer avec diligence les risques systémiques ».

Pendant ce temps, au Royaume-Uni, l’Ofcom est en train de mettre en œuvre la loi sur la sécurité en ligne.

En vertu de la loi actuelle, les plateformes de médias sociaux doivent évaluer les risques encourus par leurs utilisateurs, en assumant la responsabilité de tout contenu potentiellement dangereux.

« Ils devront prendre les mesures appropriées pour protéger leurs utilisateurs et supprimer le contenu illégal lorsqu’ils l’identifieront ou en seront informés. Et les plus grandes plateformes devront systématiquement appliquer leurs conditions de service », a déclaré un porte-parole de l’Ofcom.

S’il fait partie d’un réseau social, il incombe donc aux services et outils d’IA générative de s’autoréguler, même si les nouveaux codes de bonnes pratiques et orientations de l’Ofcom ne seront pas finalisés avant la fin de cette année.

« Nous espérons que les services seront pleinement préparés à remplir leurs nouvelles obligations lorsqu’elles entreront en vigueur. S’ils ne s’y conforment pas, nous disposerons d’un large éventail de pouvoirs coercitifs pour garantir qu’ils soient tenus pleinement responsables des sécurité de leurs utilisateurs », a déclaré l’Ofcom.