Make this article seo compatible,Let there be subheadings for the article, be in french, create at least 700 words

L’accès assisté rend l’iPhone plus facile à utiliser pour les personnes ayant des problèmes cognitifs

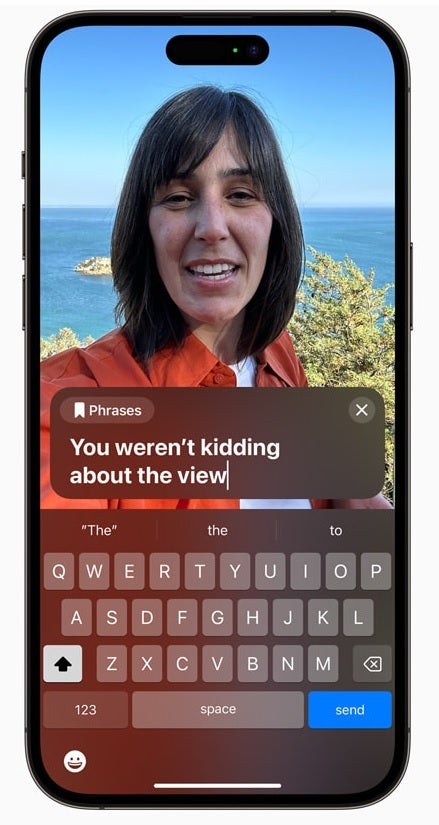

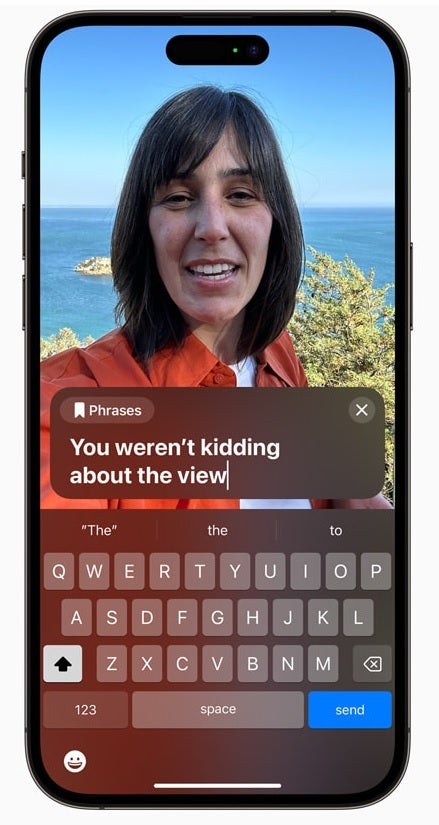

Avec Live Speech, qui sera disponible sur iPhone, iPad et Mac, pendant les appels téléphoniques et les appels FaceTime, un utilisateur peut taper ce qu’il veut dire et le faire dire à haute voix par son appareil afin qu’il puisse être entendu par les autres parties sur l’appel vocal ou vidéo. Les phrases souvent répétées par l’utilisateur peuvent être enregistrées et rapidement insérées dans des conversations avec des amis, la famille et des collègues. Apple souligne que Live Speech est « conçu pour soutenir des millions de personnes dans le monde qui ne peuvent pas parler ou qui ont perdu la parole au fil du temps ».

Live Speech permet aux personnes ayant des troubles de la parole de taper ce qu’elles veulent dire lors d’un appel vocal ou FaceTime et le téléphone l’annoncera

Pour ceux qui risquent de perdre la voix (comme le note Apple, il peut s’agir d’une personne qui a récemment reçu un diagnostic de SLA (sclérose latérale amyotrophique) ou d’une maladie qui rend progressivement la parole plus difficile, une fonctionnalité appelée Personal Voice les fera lire un ensemble aléatoire de texte pendant environ 15 minutes sur un iPhone ou un iPad. Cette fonctionnalité s’intègre au Live Speech susmentionné afin qu’un utilisateur d’iPhone ou d’iPad qui a perdu sa voix puisse toujours parler avec d’autres en utilisant une version enregistrée de leur voix .

Personal Voice permet à un utilisateur d’iPhone d’enregistrer des textes et des phrases sur l’appareil à utiliser avec la fonction Live Speech susmentionnée

Une autre fonctionnalité d’accessibilité appelée « Pointer et parler dans la loupe » aide les personnes ayant une déficience visuelle à lire les étiquettes de texte sur les boutons utilisés pour faire fonctionner les articles ménagers. À l’aide de la caméra arrière, du scanner LiDAR et de l’apprentissage automatique sur l’appareil, l’utilisateur peut focaliser la caméra de son iPhone sur le panneau de commande d’un four à micro-ondes par exemple, et lorsque l’utilisateur déplace ses doigts sur l’image d’un bouton sur l’écran tactile, l’iPhone annoncera le texte associé à ce bouton. Cela aidera ceux qui ne voient pas bien à garder le contrôle sur certaines parties de leur vie.